敬告讀者: 《中大通訊》已停刊,本網暫停更新。請移玉步造訪本校最新通訊《走進中大》網頁:https://focus.cuhk.edu.hk,閱讀大學報道和消息。

完善「深度學習」,電腦「帶眼認人」

電子工程學系

王曉剛教授

電影《未來報告》中,主角湯告魯斯從幾百萬張照片找出可能發生的罪案,防範於未然。電影中的科幻世界也要依賴真人來篩選數據,但一位中大教授的研究,卻教懂了電腦如何獨立「帶眼認人」。

中大電子工程學系計算機科學家王曉剛教授優化了電腦系統分辨圖像的技術,令電腦識別人面的能力可媲美人類。他更進一步靈電腦能偵測和識別物件和動作,包括相中人在做什麼。毋需真人親自從幾百萬張相片中篩選,電腦便可以獨立找出數據。

王教授採用一套稱為「深度學習」的技術,來模擬大腦處理映象的過程。深度學習是一套構築電腦網絡的方法,由先後任職多倫多大學及Google的Geoffrey Hinton教授連同提出,透過平行計算在數以百萬計的運算單元中傳遞信息,模仿人類大腦神經網絡的運作。一旦啟動,單元之間的互動令電腦不需人類輸入指示程式,也可以「學習」到大量參數造成的複雜性。

最常見的深度學習算式使用錯綜複雜的、非直線的以及滙集的層次來從數據中抽取特點。這種多層次的運算方式已被廣泛應用在例如顯微圖像識別乳腺癌的可能成因、改善語音識別及辨識中文字。

由1940年代起,科學家一直研究如何模仿大腦的神經網絡。在電腦開始普及的1980年代,更多研究者對這方面產生興趣;但當時的電腦運算能力有限,有關的研究也就不了了之。另一個問題是當時缺乏大型數據庫來仿製參數動輒百萬計的複雜網絡。

人類大腦的視覺皮層有六層神經組織,幫助眼睛識別物件。事實上,我們不但能利用這些資訊來識別物件,更可想像物件的其他部分是怎樣,或想像一張臉孔在不同環境下或不同表情時的模樣。

過去十年,模擬大腦的研究再次興起。高效能圖形處理器(簡稱GPU)大大提昇了運算的結果。一般的電腦只有一至八個運算核心,每個GPU則由超過一千個核心組成,大幅改善可以分辨的數據量和運算速度。

王教授解釋說:「以前新系統需要一個月才能完成學習;現在只需十個小時便可,方法就像教小孩認人:『這是你媽媽,這是你爸爸。』所以GPU的作用非常大。」另一方面,「大數據」亦帶來新的可能性,數碼媒體建立了包含數以百萬計圖像的資料庫,滿足測試搜索識別之用。

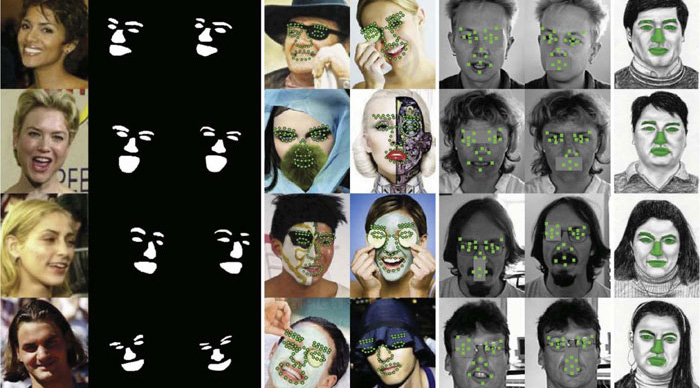

王教授的研究團隊首創將深度學習套用到區分臉孔部位,以及臉部跟身體其他部位的協調等。他亦訓練電腦系統識別相中人物的動作,如大笑、吃喝、聊電話等,並估計一個人的姿勢。

王教授開發了一個全新的臉部識別系統之後,便以一個稱為Labeled Faces in the Wild的資料庫來測試,這個資料庫由網上收集了數以千計的人面圖像。他亦解決了「遮蔽」的問題,即是在人群中識別一個人,或相片中只顯示這個人的一部分。利用深度學習,他的分層計算機系統可以辨別出相片顯示一個人的哪些部分,以及這個人擺出了什麼姿勢。

人眼可辨識兩張單獨臉孔之間共同處達97.5%,如果能見到完整的相片,準確度更達99.2%。在未有深度學習之前,最先進的電腦準確度達96.3%,但王教授成功將準確度提高到99.15%,即是電腦的準確度與人類肉眼相同。這個突破性的躍進,有賴加入更多層次的分析從而把深度學習推得更深,並且利用多個層次來共享資訊並重用組成部份。

新系統的識別準確度達全球之冠,王教授歸功於以往經驗和樂意分享資訊的精神。他表示Facebook有一支研究員團隊,將深度學習視為一個黑盒,利用自己的圖片庫並只限內部使用,而他則過去十年來與其他科學家合作。王教授說:「我們要打開這黑盒,小心設計內部結構,進一步改善設計的層次。」

今年八月,王教授的團隊在一個名為ImageNet的物件識別比賽中取得亞軍,冠軍是Google。這個比賽要求每個隊伍從互聯網上的40,000個映象中識別物件,並歸類成200個類別。

王教授的下一個挑戰,是利用電腦系統找出數以千計的行人中的某些人在作什麼,比識別臉孔難得多。另一個挑戰是令電腦可以從人的側面影像建立完整的正面影像。

倘中英文版本出現歧義,概以英文版本為準。

本文出自中大主網頁(2014年11月)