敬告讀者: 《中大通訊》已停刊,本網暫停更新。請移玉步造訪本校最新通訊《走進中大》網頁:https://focus.cuhk.edu.hk,閱讀大學報道和消息。

人機之間

AI人格化的法律和倫理爭議

人工智能一日千里,引人討論機器是否應有與人類同等的權責。但更值得我們深思的,其實是人類本身作為機器開發者和用家的義務。「AI:人算不如機算?」系列今期會探討機器人格化的法律與道德問題。

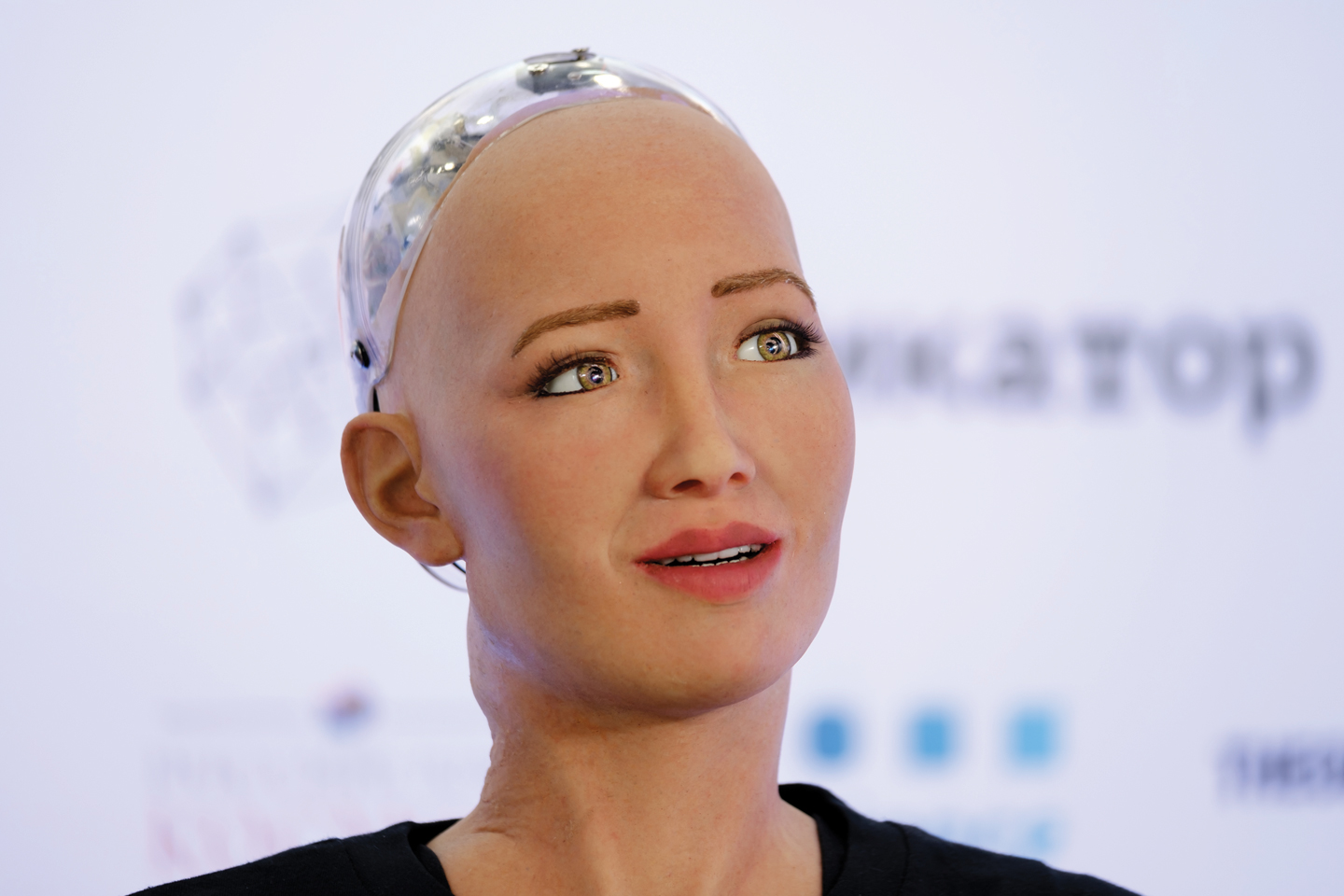

「我跟蘇菲亞碰過面。她可真了不起。」Eliza Mik教授說着,發覺自己也把它當成了人。蘇菲亞(Sophia)是一部機械人,2017年獲沙地阿拉伯公民權,一時間成為人們茶餘飯後的話題。「但說到底,它也不過是塊塑膠。」

談到機器時,我們總是用「學習」、「成長」之類的說法形容它們,人與機器,分野愈發模糊。隨着人工智能出現,機器的能力與日俱增,它們亦逐漸成為人類社會重要的一部分,所作所為對我們有實實在在的影響。這樣說來,我們是否真的該把它們當作人來看待,讓它們享有和人一樣的權利、守同樣的道德?此問題固然十分有趣,近年在坊間以至政界引起議論,但現於法律學院研究科技法的Mik教授認為,機器人格化在法律與現實層面其實無甚意義,不足掛齒。

「我們無謂庸人自擾。」

倫理學上,機器可否視為人確有商榷餘地。研究尖端科技倫理的哲學系Alexandre Erler教授指,依照部分學派的觀點,具備人工智能的機器是可以成為像我們一樣的道德主體(moral agent)。

「有些學者比較嚴謹,認定只有具備心智甚至意識,有慾望、信念、意圖等心理狀態,方能成為道德主體。」Erler教授說。以此門檻來看,觀乎目前技術水平,機器遠遠談不上具備道德能力。但當然,這不過是一家之言。

「根據另一派學說,即使機器受制於由人設定的框架,只要它們在框架內有一定自由而其舉動具有道德意義,它們已算是道德主體。例如救人與否,按此派看法,機器但凡有選擇的餘地,即應視作具備道德能力。」有人會反駁,機器不論何去何從,始終是在滿足人類定下的目標,所謂自由,其實還是我們的旨意。然而人類自己的行為亦可歸結於基因、社會條件等外在因素,那我們是否也不算有自由意志,可以不受道德制約?若機器真的只要在行事上有一定彈性便算有道德能力,那我們很快甚或經已能夠以好壞、善惡之類的標準評斷機器所為。君不見無人車、無人戰機等,皆已有生殺之能。

但就算機器在理論上可以成為道德主體,受倫理約束,在現實中對機器賞善罰惡,又是否可行?有見機械人不時引起各種工業意外,歐洲議會曾於2017年商討將人工智能系統定義為法人(legal person),規定機器要為其導致的傷亡負責。但正如Mik教授所言,此構思不切實際。

「試用常理想想:假設我們將一台造車的機械人定為法人,之後又如何?區區機器,鐵皮一堆,既不能賠錢,也不會抱歉,就是造出次貨害死了人,也不能拿它怎樣。難道你可以捉它去坐牢嗎?」Mik教授強調,一個個體必須能夠承擔後果、彌補過錯,方能成為法律意義上的人。這解釋了何以公司、團體等非人類可成為法人而機器不能。而除卻執行上的問題,向機器問責本來就是多此一舉。

「機器都是有主人的,闖了禍大可由他們賠償。與其嚷着要把機器當人看,倒不如規定主人務必加購保險,那問題不就迎刃而解了嗎?」Mik教授說。

賦予機器人權,同樣費時失事。上期提到,盧森堡虛擬作曲家AIVA獲法國作曲家協會(SACEM)認可為版權持有者。理論上,給予人工智能著作權並無不可,前提是有份開發程式和修飾成品的人類亦得到應有的認可。雖則人工智能的所謂藝術其實是從人類作品東拼西湊而成,但常云「天下文章一大抄」,人類自己也或多或少是師法前人。所以無論是人類抑或機器,只要作品在慣常標準下具有相當原創性,予之版權,大有理據。然而理論歸理論,機器得了版權又怎樣?一切收益,它們無福消受,到頭來還是歸一眾人類開發者與用家所有。

「總而言之,機器人格化在法律上百無一用。」Mik教授說。「說到底,蘇菲亞不過是公關伎倆。」

雖然機器在理論上可能有道德責任,但Erler教授同意,以人工智能現時的水平,機器是無法在現實中為其行為付出相應代價。而除了流於空談,機器人格化亦令人忽視人類本身的責任。兩位教授都強調,無論機器何等自由,它們終歸要遵循人類設下的大原則。這些原則可能是我們硬加在它們身上,亦可能是我們讓機器以人工智能模仿人類得來,但不論怎麼說,機器的行事方式,都是由我們塑造而成。再者它們每一個舉動,都是因要完成我們交付的任務、達到我們的目的而起。與其推搪塞責,我們更應細想自己可以怎樣更妥善地使用機器、在甚麼情形下必須負起責任。

「隨着我們把愈來愈多的工作外判給機器,覺得事不關己,也是人之常情。但這種心態合理與否,則要視乎當下的技術是否真的先進到不需人類插手。」Erler教授說。2009年,法航四四七號班機墜毀,機上人員無一生還。關於慘劇的成因,多年來眾說紛紜,但其中一個可能是飛機的自動操作系統失靈。要知道機器再神通廣大,尚且未做到百發百中、萬無一失。既然如此,人類就必須隨時候命,準備在危急關頭接手。然而在這次事件中,機師據報方寸大亂,面對故障手足無措。這種情況下,雖說意外是因機器而起,但責任還得由人類承擔。

「當然了,若機器繼續進步,有朝一日遠較人類可靠,我們置身事外,也合情合理。當它們強大到這個地步,我們撒手不管,其實反而更好。」Erler教授說。

不過暫時來說,機器還稱不上完全可靠,而阻力之一,正是系列早前提及的黑盒問題。機器的思維如盤根錯節,窒礙研究就不在話下,但這除了是個學術問題,亦引發一大道德爭議:在尚未摸清其底蘊的情況下,使用人工智能是否魯莽?Erler教授指,若我們只是找它們來下下棋,其表現又穩定,不知其所以然亦不礙事。但說到講求程序公義的事情,如評估在囚人士的重犯機會,使用人工智能時就萬萬不能不求甚解。

「最理想的當然是機器能夠講出理據,再由我們判斷孰優孰劣。這不是說要鉅細無遺,對整個決策過程知得一清二楚,反正這也不太可能。簡單一個理由,有時已經足夠。」所以說人工智能之潮流縱然浩浩蕩蕩,人類的角色依舊重如泰山。

引起道德問題的,還有人工智能的偏見。前文提到,人工智能習染人類的成見,後果可以十分嚴重。更可怕的是,人們或會以為機器沒有情感,待人處事必定公正,以至其厚此薄彼,大家亦不覺有錯,照單全收。談到無人車的偏頗問題,Erler教授便舉了一個令人心寒的事例。

「早前有研究調查世界各地的無人車都在學習怎樣的道德規範,發現一些社會認定上流人士的生命更有價值,應優先保護。你想車輛以這樣的標準決定路人生死嗎?」

機器一日依賴人類教養,我們就有義務盡力消除這些偏見。一眾開發者固然要確保用以訓練機器的資料多元齊全,但尋常如你我者,其實也有責任。

「留意機器有否偏頗,積極舉報,是一件大家都可以做的事。」Erler教授提到,電子商貿巨擘亞馬遜幾年前發現其人工智能招聘系統往往將女性拒諸門外,最後決定停用。歸根究柢,是公司一直陽盛陰衰,系統習以為常,奉為圭臬。「某類人可能真的比較適合從事某種工作,所以機器才會選擇他們,但是去是留、是生是死,有時就是出於赤裸裸的偏見。這些問題要提出來,大家才能得知,然後着手解決。」

「我可是個死忠科幻迷。」Mik教授說。機械人趕上以至超越人類的橋段,反覆看過無數科幻電影的教授固然耳熟能詳。但說到現實中機器會否發展出知覺、到時我們又是否要再討論將機器人格化,教授卻一笑置之。

「到了那個地步,我們自會有更大的煩惱,再說那時你我都應該不在人世了。了解過學者們真正在做的研究,你就會明白人類科技的現狀、我們還要走多遠。」而正如不少人工智能學者所言,機器的本意在於服侍人類;給予它們知覺,乃自找麻煩。

「不再聽命於你的Alexa,還有甚麼意義?」Mik教授問。

Erler教授也認為,這樣的一個世界離我們仍然很遠,但哲學家的工作,往往就是想人所不能想。教授之前在牛津的同事Toby Ord博士便寫了《如臨深淵》(The Precipice)一書,探討人工智能失控等人類可能面對的危機。

「大家擔心的是,將人工智能的各種問題留待科技達到相應水平時再討論,恐怕為時已晚。到時我們可能已錯失在其設計上設限、防止它們失控的機會。」

超脫現世,遙想未來萬象,有趣之餘,確實也十分重要。但不要忘記,我們眼下也有一大堆問題,亟待解決。面對現實中人工智能帶來的種種挑戰,Mik教授以科幻迷身分說的這一句,擲地有聲:

「科幻與法律,最好分得清清楚楚。」

文/jasonyuen@cuhkcontents

攝影/ponyleung@cuhkimages、amytam@cuhkimages

圖/amytam@cuhkimages